Die Zukunft hat bereits begonnen

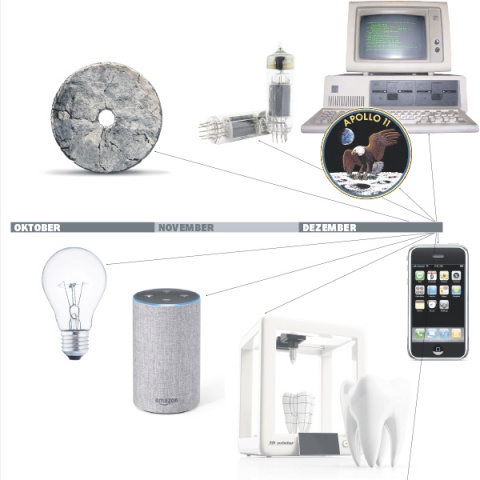

Begeben wir uns auf eine kleine Zeitreise in die Vergangenheit, wagen wir ein Gedankenspiel, in dem wir die 300.000 Jahre Menschheitsgeschichte auf ein einziges Kalenderjahr komprimieren? Los geht’s. Der Homo Sapiens taucht zu Beginn dieses gedanklichen Jahres erstmals am Neujahrsmorgen exakt um Mitternacht auf – in Afrika. Am 5. November beginnt die Besiedelung Europas. Und dann geht es Schlag auf Schlag.

Am 24. Dezember um 17 Uhr taucht das Rad auf; am selben Tag, um 23 Uhr, beginnt die Kupferzeit. Am 26. Dezember folgt die Bronzezeit, einen Tag später die Eisenzeit. Beton wird erstmals am 27. Dezember verwendet. Am Silvestertag um 7.20 Uhr erfindet Gutenberg den Buchdruck. Rund eineinhalb Stunden später entdeckt Christoph Columbus Amerika. Um 12 Uhr werden das Fernrohr, um 16 Uhr Gussstahl und 40 Minuten später die Dampfmaschine erfunden. Um 18.30 Uhr rattert der erste Benzinmotor. Um 19.40 Uhr klingelt erstmals ein Telefon. 15 Minuten später erfindet Edison die Glühlampe und um 20.40 Uhr gelingt den Gebrüdern Wright der erste Flug mit einem Flugzeug. Die erste Fernsehübertragung findet um 21.26 Uhr statt. Um 21.47 Uhr konstruiert Konrad Zuse den ersten Computer. Um 22 Uhr wird der Transistor erfunden. Die erste Mondlandung flimmert um 22.36 Uhr über unsere Fernsehgeräte, sieben Minuten später gibt es den ersten Mikroprozessor, gleichzeitig beginnt damit die Digitalisierung. Um 22.57 Uhr kommt der PC, um 23.11 Uhr das Internet. Um 23.42 Uhr stellt Apple sein erstes Smartphone vor.

Alte Irrtümer

300.000 Jahre lang gab es kaum technische Entwicklung. Erst mit den 1950er-Jahren kam die Beschleunigung, die Rasanz; bis zum heutigen Tag wird ständig alles schneller und schneller. Kann es in diesem Tempo weitergehen? Auch wenn Charles Duell, Chef des US-Patentamtes, im Jahr 1899 noch sagte: „Alles, was erfunden werden kann, wurde bereits erfunden.“ Und Ken Olson, Chef von „Digital Equipment“, 1977 gemeint hat: „Es gibt keinen Grund, warum Menschen zu Hause einen Computer haben sollten.“ „Digital Equipment“ war damals mit 100.000 Angestellten übrigens der zweitgrößte Computerhersteller der Welt. Acht Jahre später gab es das Unternehmen nicht mehr. Aber auch der bei uns geschätzte Trend- und Zukunftsforscher Matthias Horx hatte 2001 noch gesagt: „Internet wird kein Massenmedium“ und vor nicht einmal acht Jahren: „Von Facebook wird in fünf bis sechs Jahren kein Mensch mehr reden“. Fazit? Was heute Realität ist, war vorher in den wenigsten Fällen vorstellbar. Wie sagte doch der Schauspieler Sir Peter Ustinov: „Die letzte Stimme, die man hört, bevor die Welt explodiert, wird die Stimme eines Experten sein, der sagt: ,Das ist technisch unmöglich!‘“ Wird es also in diesem Tempo weitergehen? Ja!

Produktion von Wissen

Die Zahl der Wissenschaftler, Ingenieure und Techniker nimmt weltweit immer weiter zu. Sie „produzieren“ immer mehr Wissen. Technische Neuerungen kommen in immer kürzeren Abständen auf den Markt. Wir werden also in den nächsten Jahren einen technologischen Fortschritt erleben, der alles Bisherige in den Schatten stellen wird.

Es ist gerade 60 Jahre her. Ich habe es selbst erlebt, den Übergang von der Röhre zum Transistor. Die ersten Transistorradios wurden noch mit der Zahl der verbauten Transistoren 2, 3 und dann 16 beworben. Der erste integrierte Schaltkreis beziehungsweise der erste Chip hatte gerade einmal 24, der erste Mikroprozessor im Jahr 1971 bereits 2250 Transistoren. Auf einem heute gebräuchlichen 16 Gigabyte Speicherchip sind bereits 64 Milliarden Transistoren integriert – und das auf einer Fläche von 3,5 Quadrat-Millimetern! Und Samsung bringt in diesen Tagen einen 512-GB-Speicherchip heraus mit kaum vorstellbaren 4096 Milliarden Transistoren!

Seit etwa 40 Jahren verdoppelt sich die Leistung von Computern alle zwölf bis 24 Monate. Das heißt, in etwa eineinhalb Jahren wird sich die ohnehin schon hohe Leistungsfähigkeit von Computern und Handys noch einmal verdoppeln, in weiteren 18 Monaten schon wieder, und so weiter und so fort. Eine weitere Beschleunigung wird es mit den bereits in den Startlöchern stehenden Quantencomputern geben. Und es hört nicht auf. Es ist kein Ende absehbar.

Künstliche Intelligenz

Die Diskussion über „künstliche Intelligenz“, ob, wann und wie Computer uns Menschen einmal überholen werden, läuft derzeit auf Hochtouren. Fachleute aus dem Weißen Haus haben Ende 2016 (also noch vor Donald Trump) angeregt, sich auf ein Leben vorzubereiten, in dem künstliche Intelligenz eine dominante Rolle spielt. „Innerhalb von hundert Jahren werden Computer intelligenter sein als Menschen“, sagt der kürzlich verstorbene weltbekannte Physiker Stephen Hawking. Noch am 8. Jänner feierte er seinen 76. Geburtstag.

Wenn wir von künstlicher Intelligenz reden, dann denken wir meist an Hochleistungs-Computer, an Datenbanken, komplizierte Formeln und Algorithmen. Neue KI-Systeme – „KI“ steht für „künstliche Intelligenz“ –, die nach dem „Deep-Learning-Verfahren“ arbeiten, haben nicht mehr viel mit herkömmlichen Computern und Software gemein. Im Gegenteil. Hier findet man nur relativ simple vordefinierte Strukturen, vergleichbar mit dem Neuronengeflecht im menschlichen Gehirn. Sie lernen auch ähnlich wie Menschen. Ihre Intelligenz beziehen sie nicht aus Formeln, Tabellen oder Datenbanken, sondern aus Mustern, die sie selbstständig aus den verschiedensten Informationsquellen gewinnen – aus Büchern, Bildern, Tonaufnahmen …

Eine Niederlage für den Menschen

1997 gelang es dem IBM-Programm „Deep Blue“, den damaligen Schachweltmeister Garri Kasparow in einem Wettkampf unter Turnierbedingungen zu schlagen. Das Go-Spiel ist noch komplexer als Schach. Im vergangenen Jahr gelang es mit einem von Google entwickelten System, den weltbesten Go-Spieler, den Südkoreaner Lee Sedol, zu besiegen. Das Verblüffende daran? Niemand hatte dieser Maschine Go beigebracht. Sie hat sich die Regeln und die grundlegenden Spielzüge durch Beobachtung menschlicher Go-Partien selbst erschlossen. Niemand hat das System trainiert. Es hat sich selbst optimiert, indem es mehrere Millionen Go-Partien gegen sich selbst spielte. Die Maschine war in der Lage, selbst zu lernen und sich selbstständig weiterzuentwickeln. Das Beste: Niemand weiß, warum es einen bestimmten Zug macht. Vor genau einem Jahr folgte die nächste Niederlage für den Menschen: Ein von Experten der Carnegie-Mellon-Universität programmiertes KI-System gewann erstmals gegen die besten, professionellen Pokerspieler.

Die kanadische Firma „Lyrebird“ hat sich auf Stimmenimitation durch künstliche Intelligenz spezialisiert. Im Internet kann man ein Gespräch zwischen dem amtierenden US-Präsidenten Donald Trump und seinem Vorgänger Barack Obama hören. Täuschend echt, und doch ist kein Satz dieses Gesprächs jemals so gefallen.

Wissenschaftler der US-Firma „Nvidia“, Spezialist für Computergrafiken, haben kürzlich gezeigt, wie sich auch die Anschauung der Wirklichkeit manipulieren lässt. Mithilfe von künstlicher Intelligenz lassen sich Bilder von Tieren, menschliche Gesichter oder Straßenszenen generieren, die es so nie gegeben hat.

KI-Systeme können inzwischen nicht mehr nur Fotos erkennen, sortieren und interpretieren. Sie können sie auch wirklichkeitsgetreu herstellen. Aus Winter wird Sommer, aus Sonne wird Regen, den es so nie gegeben hat.

Vielfältige Aufgaben

Die künstliche Intelligenz wird natürlich auch für ganz andere Aufgaben eingesetzt, zum Beispiel für die Übersetzung, Spracherkennung und neuerdings auch für Sprachsteuerung. Stichwort: Google Translate, Siri von Apple oder Alexa von Amazon.

In der Medizin werden KI-Systeme bereits für die Diagnose, bei der Analyse von Blutproben und der DNA eingesetzt. Das KI-System „Watson“ von IBM ist jetzt schon in der Lage, genetische Informationen von Patienten mit den genetischen Daten von 20 Millionen klinischen Krebs-Studien innert weniger Minuten zu vergleichen. Die Zielsicherheit der Diagnosen verblüffen Wissenschaftler und Ärzte gleichermaßen.

Ähnlich bei der Auswertung von Röntgen-, CT- und MRT-Bildern: Während ein Radiologe im Laufe seines Lebens vielleicht Tausende von Bildern gesehen und ausgewertet hat, hat das System „Watson“ bereits zig Millionen samt den damit verbundenen Diagnosen und tatsächlichen Krankheitsverläufen gespeichert. Hier kann der Mensch schon heute nicht mehr mithalten.

KI-Systeme stoßen in völlig neue Bereiche vor. Sie erobern unsere Büros, unsere Haushalte, sie werden den Krankenhaus- und Pflegebereich revolutionieren. Selbstfahrende Autos oder selbststeuernde Flugzeuge sind längst keine Science-Fiction mehr und autonome Waffensysteme sind (leider) bereits Realität.

Die Digitalisierung erobert unsere Welt! Wenn wir Bücher nicht mehr im Laden kaufen, sondern online als E-Book auf unser Lesegerät laden, wenn immer mehr das Programm-Fernsehen links liegen lassen und lieber Filme über Streaming-Anbieter anschauen, wenn Ärzte Patienten per Video-Chat beraten oder wenn das Blut, das Gewebe oder das Röntgenbild von Robotern untersucht wird, oder wenn uns schon bald unser Auto nach der Feier autonom nach Hause fährt und sich anschließend selbständig einen Parkplatz sucht – dann ist es Digitalisierung.

50 Milliarden vernetzte Geräte

In den kommenden Jahren werden immer mehr Gegenstände miteinander kommunizieren. Laut Intel wird es 2020 bereits 50 Milliarden vernetzte Geräte auf der Erde geben. Tag für Tag produziert die Menschheit einen gigantischen Datenberg. Täglich kommen schätzungsweise etwa 2,5 Quintillionen Bytes dazu. Das ist eine Zahl mit 30 Nullen. Würde man nur die im vergangenen Jahr gesammelte Menge an digitalen Daten auf DVDs brennen und stapeln, dann wäre dieser Turm so hoch wie die Strecke von der Erde zum Mond und wieder zurück. Alleine im letzten Jahr sind so viele Daten hinzugekommen wie zuvor in der gesamten Menschheitsgeschichte.

Alibaba, das chinesische Pendant zu Amazon, bietet in seinem Internetshop mehr als 60.000 Marken mit insgesamt 15 Millionen Produkten an. Am 11. November 2017, dem chinesischen „Single Day“, wurden innerhalb der ersten Stunde Waren im Wert von 8,5 Milliarden Euro und über den ganzen Tag im Wert von 21,8 Milliarden Euro verkauft. Es gingen an diesem Tag 812 Millionen Bestellungen ein. 90 Prozent der Käufe wurden über Smartphones getätigt. Das dazugehörende Finanzportal „Alipay“ hat an diesem Tag 1,5 Milliarden Finanztransaktionen durchgeführt – in Spitzenzeiten bis zu 325.000 Finanztransaktionen pro Sekunde.

Immense Möglichkeiten

Es ist bereits Realität, dass Teile nicht mehr physisch verschickt werden müssen, sondern über das Internet mit Lichtgeschwindigkeit lediglich der Bauplan gesendet und die Teile dann zu Hause oder in der Firma mit einem 3D-Drucker hergestellt werden. Solche drucken mittlerweile neben Kunststoff auch Stahl oder Beton, drucken Gehäuse, Schrauben, Ersatzteile für Züge, Autoteile, Motoren, ja sogar ganze Autos und ganze Gebäude, drucken Zähne, Implantate, Hüftgelenke oder Knochen. Mit Bio-Zellen werden Herzklappen hergestellt und in Wien wurde unlängst sogar ein menschliches Ohr gedruckt. Dies sind nur ein paar Beispiele, was die Digitalisierung bereits bewirkt und was noch kommen kann.

Denn die eng mit dieser Digitalisierung verknüpften Technologie-Trends sind dabei, nicht nur die Art und Weise des Wirtschaftens umzukrempeln, sie sind auch die Basis für komplett neue Geschäftsprozesse sowie für völlig neue Unternehmungen. Milliardenschwer bewertete Start-ups – selbst in etablierten Branchen – geben einen ersten Vorgeschmack auf diese Veränderungen. Unternehmen, die das noch nicht erkannt haben, werden zurückfallen. Wir haben gesehen, dass Start-ups oder Nischenanbieter in vielen Branchen eine Revolution losgetreten haben. So manch früherer Platzhirsch kämpft, wenn die Schockstarre zu lange dauert, am Ende gar ums nackte Überleben.

„Too big to fail“? Von wegen

Laut Schätzungen von MIT-Wissenschaftlern werden bis zum Jahr 2025 rund 40 Prozent der heute 500 umsatzstärksten Unternehmen von der Bildfläche verschwinden. Dass dies durchaus eintreffen könnte, beweist ein Blick in die Vergangenheit: In den USA sind seit dem Jahr 2000 gut die Hälfte der Fortune-500-Firmen verschwunden. Hauptauslöser war auch hier vor allem die Digitalisierung. Fazit: „Too big to fail“ stimmt nicht mehr.

Wir sprechen daher bei der Digitalisierung auch von einer disruptiven Technologie, die eine bestehende Technologie, aber auch eine bestehende Industrie oder eine bestehende Dienstleistung vollständig verdrängen kann. Disruptive Innovationen brechen etablierte Märkte auf und verändern die Spielregeln ganzer Branchen. „Schöpferische Zerstörung“ nannte das schon vor mehr als 70 Jahren der große Ökonom Joseph Schumpeter.

Was jenen blüht, die von dieser Entwicklung überrollt werden, wird am Beispiel von einst klingenden Namen wie Nokia oder Kodak deutlich. Kodak, 1888 gegründet, hatte einmal 150.000 Mitarbeiter und war 2012 insolvent. Dabei haben wir nicht aufgehört, Fotos zu knipsen. Im Gegenteil, es wird fotografiert wie noch nie, allein im Jahr 2015 so viel wie in der gesamten Geschichte der Menschheit zuvor – nur Kodak ist nicht mehr dabei, hat die Digitalisierung verschlafen. Nokia war einmal Marktführer im Mobilfunk. Dennoch wurde 2007 sein Ende besiegelt, als Apple das iPhone auf den Markt brachte. Apple ist mit einem Börsenwert von über 900 Milliarden Dollar heute das höchst bewertete Unternehmen der Welt.

Praktisch alle bahnbrechenden Technologiesprünge, etwa die Entwicklung von der Schreibmaschine zur Textverarbeitung am Computer oder von der Petroleumlampe zum elektrischen Licht, wurden von den Branchenführern verpasst. Es sind immer die kleinen und jungen Unternehmen, die auf eine neue Technologie setzen und dann alte Strukturen im Markt aufbrechen oder ganz zerstören. Sie entwickeln eigene Märkte und schaffen neue Geschäftsmodelle, oft sogar neue Branchen. Die Zukunft hat bereits begonnen!

Kommentare